مقدمه: نیاز به شتابدهندهها در دیتاسنترهای نسل جدید

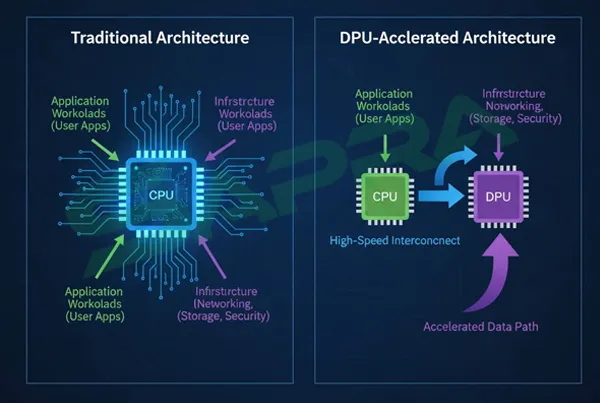

نیاز به پردازش دادهها با سرعت نور، به ویژه برای بارهای کاری (Workloads) مانند هوش مصنوعی (AI)، یادگیری ماشینی (ML)، تجزیه و تحلیل کلان داده (Big Data Analytics) و شبکهبندی با کارایی فوقالعاده بالا، فراتر از توان پردازندههای مرکزی (CPU) سنتی رفته است. اگرچه CPUها، مانند پردازندههایی که در معماری قابل اعتمادی که با سرور اچ پی بهدست میآیند، همچنان مغز دیتاسنتر هستند، اما برای انجام وظایف موازی سنگین و عملیات ورودی/خروجی (I/O) شبکه، نیاز به کمک دارند.

اینجاست که شتابدهندههای سختافزاری (Hardware Accelerators) مانند FPGAها (Field-Programmable Gate Arrays) و نسل جدید DPUها (Data Processing Units) وارد میدان میشوند. این دستگاهها با هدف آفلود کردن (Offloading) و شتاب دادن به وظایف خاص از CPU، کارایی و توان عملیاتی کل سیستم را افزایش میدهند. با این حال، استفاده از این تکنولوژیهای نوظهور، چالشهای پیچیدهای را در پیادهسازی، مدیریت و توسعه به همراه دارد.

معرفی FPGAs و DPUs و تفاوتهای کلیدی

برای درک چالشها، ابتدا باید ماهیت و تفاوتهای این دو تکنولوژی را بشناسیم.

۱. FPGAs (Field-Programmable Gate Arrays)

- ماهیت: FPGA یک تراشه نیمههادی است که پس از ساخت، میتوان سختافزار آن را توسط کاربر برنامهریزی مجدد کرد تا عملکرد یک مدار مجتمع خاص (ASIC) را تقلید کند.

- مزیت اصلی: انعطافپذیری فوقالعاده. FPGAها میتوانند برای شتاب دادن به وظایفی که ماهیت آنها مرتباً تغییر میکند (مانند الگوریتمهای رمزنگاری جدید یا شبکههای عصبی نوظهور) به طور کامل بهینه شوند. آنها برای پردازش موازی ریزدانه (Fine-Grained Parallelism) عالی هستند.

- کاربرد: رمزنگاری/رمزگشایی با تأخیر کم، پردازش سیگنال، معاملات مالی با فرکانس بالا (HFT) و شتابدهی به بخشهای خاصی از ML.

۲. DPUs (Data Processing Units)

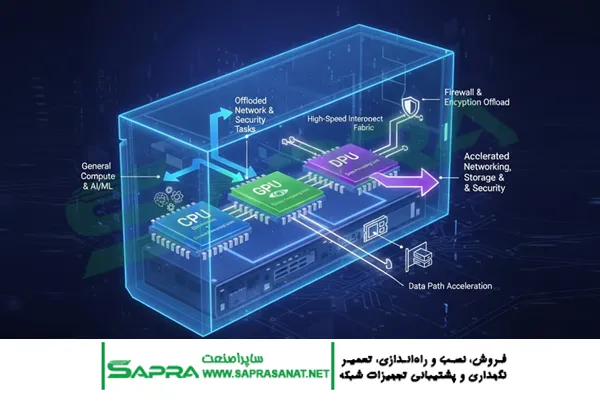

- ماهیت: DPU، که اغلب به عنوان نسل سوم پردازندهها در کنار CPU و GPU شناخته میشود، یک تراشه کاملاً یکپارچه (SoC) است که برای پردازش وظایف شبکه، ذخیرهسازی و امنیت طراحی شده است. DPUها معمولاً شامل:

- هستههای پردازشی مبتنی بر ARM (برای اجرای سیستم عامل DPU)

- شتابدهندههای سختافزاری اختصاصی (برای رمزنگاری، فشردهسازی و فایروال)

- کنترلرهای شبکه و I/O پرسرعت.

- مزیت اصلی: آفلود کردن زیرساخت. هدف اصلی DPUها برداشتن بار پردازشی زیرساخت (مانند مجازیسازی شبکه، امنیت، ذخیرهسازی و مدیریت) از روی CPU اصلی سرور است تا CPU بتواند ۱۰۰٪ بر روی Workloads کاربردی تمرکز کند.

- کاربرد: زیرساختهای Hyper-Converged (HCI)، مجازیسازی شبکه (NFV)، امنیت Zero Trust در لبه سرور، و SDN (Software-Defined Networking).

۳. تفاوت کلیدی: انعطافپذیری در مقابل کارایی زیرساخت

| ویژگی | FPGA | DPU |

| هدف اصلی | شتاب دادن به الگوریتمهای متغیر و موازی کاربردی | آفلود کردن و شتاب دادن به وظایف زیرساختی (شبکه/ذخیرهسازی) |

| سختافزار | گیتهای منطقی قابل برنامهریزی | هستههای ARM، شتابدهندههای تخصصی و NIC پرسرعت |

| برنامهنویسی | سخت (زبانهای توصیف سختافزار مانند VHDL/Verilog یا C++) | نسبتاً آسان (C/C++ و APIهای استاندارد لینوکس) |

| معماری | سفارشیسازی کامل مدار | معماری ثابت و هدفمند |

چالشهای کلیدی در استفاده از FPGAs

FPGAها با وجود قدرت زیاد، بزرگترین موانع را در زمینه توسعه و پیادهسازی ایجاد میکنند.

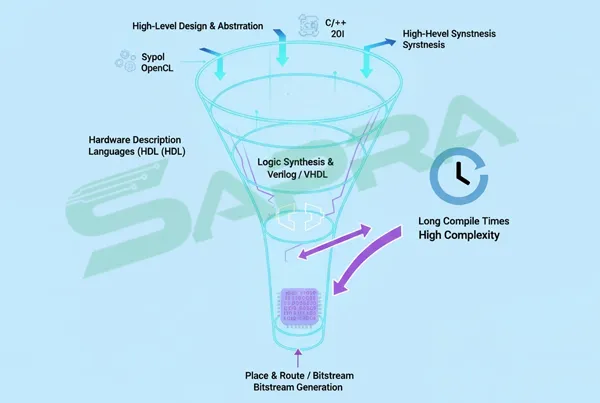

۱. پیچیدگی و زمان توسعه (Development Complexity)

- برنامهنویسی سختافزار (Hardware Description): برنامهنویسی FPGAها نیازمند دانش عمیق در زمینه طراحی سختافزار و زبانهایی مانند Verilog یا VHDL است، نه صرفاً کدنویسی نرمافزار. حتی با استفاده از رویکردهای سطح بالاتر (مانند OpenCL یا C++ با HLS)، منحنی یادگیری بسیار شیبدار است.

- زمان طولانی پیادهسازی: فرآیند تبدیل کد به پیکربندی گیتها (Synthesis و Place & Route) بسیار زمانبر است. یک تغییر کوچک در کد میتواند به ساعتها زمان کامپایل نیاز داشته باشد.

- کمیاب بودن متخصص: متخصصانی که همزمان به توسعه نرمافزار، طراحی سختافزار و معماری سرور مسلط باشند، بسیار کمیاب و گران هستند.

۲. چالشهای مدیریت و استقرار

- مدیریت Firmware/Bitstream: هر FPGA نیاز به یک Bitstream دارد که پیکربندی سختافزاری آن را مشخص میکند. مدیریت نسخهها و اطمینان از اینکه هر FPGA با Bitstream صحیح برای Workload در حال اجرا بارگذاری شده، یک کابوس مدیریتی است.

- مدل سرویسدهی (As a Service): به اشتراکگذاری FPGA بین چندین کاربر (Multi-Tenancy) یا سرویسدهی FPGAها به عنوان یک منبع مشترک در یک محیط مجازیسازی شده، بسیار پیچیده است و نیازمند فریمورکهای سختافزاری و نرمافزاری خاص است.

۳. مسائل حرارتی و مصرف انرژی

FPGAها میتوانند انرژی بسیار زیادی مصرف کنند و گرمای زیادی تولید کنند، که مدیریت خنککنندگی (Cooling) و تغذیه برق (Power Delivery) در سرورهای استاندارد را، حتی در پلتفرمهای سازمانی مانند سرورهای HPE، با چالش روبرو میکند.

چالشهای کلیدی در استفاده از DPUs

DPUها با هدف سادهسازی زیرساخت معرفی شدهاند، اما چالشهای آنها بیشتر در زمینه مدیریت عملیات، همگرایی با امنیت و وابستگی به فروشنده است.

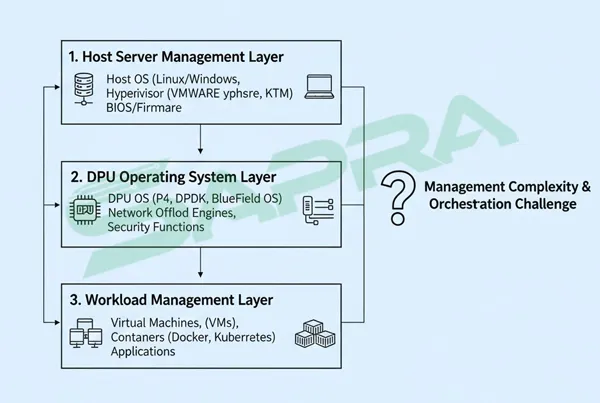

۱. معماری مدیریتی سهسطحی (Three-Tier Management)

معماری DPU یک لایه مدیریتی جدید اضافه میکند:

- مدیریت سرور میزبان (CPU): سیستم عامل اصلی و Workloads کاربردی.

- مدیریت DPU OS: سیستم عامل DPU (معمولاً نوعی لینوکس سفارشی) و Imageهای نرمافزار زیرساخت (مانند V-Switch و فایروال).

- مدیریت کانتینر/مجازیسازها: Hypervisor و Workloads نهایی کاربر.

این پیچیدگی، نیاز به ابزارهای مدیریتی یکپارچه (مانند HPE Synergy یا ابزارهای مدیریت DPU از فروشندگان بزرگ) را برای مدیریت Imageها، Firmware و بهروزرسانیهای DPU به صورت متمرکز، حیاتی میکند.

۲. چالشهای امنیتی و حریم خصوصی

DPUها به دلیل دسترسی مستقیم به دادههای شبکه، موقعیت امنیتی منحصربهفردی دارند.

- حمله به ریشه اعتماد (Root of Trust Attack): اگر یک مهاجم بتواند کنترل سیستم عامل DPU را به دست آورد، میتواند به تمام ترافیک شبکه، رمزنگاری و سیستمهای زیرساختی دسترسی کامل پیدا کند؛ زیرا DPU در یک موقعیت ممتاز در زیرساخت قرار دارد.

- جدا شدن عملکرد (Isolation): اطمینان از اینکه عملکرد زیرساخت DPU به طور کامل از Workloads کاربردی روی CPU جدا شده است (برای جلوگیری از نشت داده یا حملات متقاطع)، نیازمند پیادهسازیهای سختگیرانه سختافزاری و نرمافزاری است.

۳. استانداردسازی و وابستگی به فروشنده (Vendor Lock-in)

- عدم وجود استاندارد واحد: بر خلاف NICهای استاندارد، DPUها هنوز در حال تکامل هستند. هر فروشنده بزرگ (NVIDIA/Mellanox, Intel, AMD/Pensando) معماری DPU و مجموعه ابزارهای نرمافزاری خود را دارد. این امر جابهجایی بین پلتفرمهای مختلف و حفظ یکپارچگی ابزارهای مدیریتی را برای مدیران IT بسیار سخت میکند.

- پشتیبانی نرمافزاری: برای بهرهگیری کامل از قابلیتهای Offloading DPU، نرمافزارهای Hypervisor، مجازیسازی شبکه و سیستم عامل باید به طور خاص با معماری DPU مورد نظر سازگار باشند و این پشتیبانی ممکن است در محیطهای متنباز (Open Source) یا سیستم عاملهای قدیمیتر وجود نداشته باشد.

همگرایی و آینده شتابدهندهها

علیرغم چالشها، همگرایی این تکنولوژیها با زیرساخت استاندارد سرور، در حال پیشرفت است.

۱. توسعه نرمافزار سادهتر

فروشندگان FPGA در حال تلاش برای توسعه فریمورکهای سطح بالا (High-Level Synthesis – HLS) هستند تا برنامهنویسی با زبانهای رایجتر مانند Python یا C++ را امکانپذیر کنند. این امر به تدریج چالش زمان توسعه را کاهش خواهد داد.

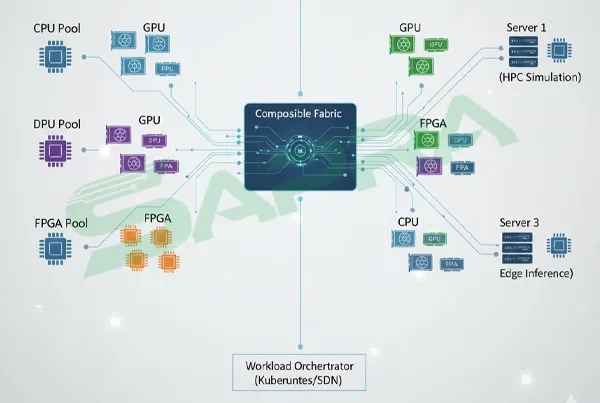

۲. زیرساخت Composer و Composable

معماریهای Composable Infrastructure (مانند HPE Synergy) اجازه میدهند تا منابع سختافزاری (CPU، GPU، DPU و FPGA) به صورت پویا و بر اساس نیاز Workload به سرورهای مجازی اختصاص داده شوند. این امر به مدیریت پیچیده منابع شتابدهنده کمک شایانی میکند.

۳. نقش مهم در AI و Edge Computing

- AI Inference: با Offload کردن امنیت و شبکه، DPUها سرعت پاسخدهی (Latency) را در زیرساختهای AI Inference (استنتاج هوش مصنوعی) در لبه شبکه (Edge) به حداقل میرسانند.

- پردازش توزیعشده: FPGAها و DPUها با هم کار خواهند کرد: DPU وظایف زیرساختی را مدیریت میکند و FPGA برای شتاب دادن به الگوریتمهای نوظهور ML در یک محیط سروری در حال تغییر، بهینه میشود.

نتیجهگیری

استفاده از FPGAs و DPUs برای سرورهای مدرن یک ضرورت است تا بتوانند تقاضای روزافزون Workloads پرمصرف داده را برآورده سازند. با این حال، سازمانها باید با چشمانی باز وارد این حوزه شوند. چالشهای استفاده از FPGAها عمدتاً فنی و مربوط به پیچیدگی برنامهنویسی و توسعه است، در حالی که چالشهای DPUها بیشتر عملیاتی و مدیریتی بوده و در زمینه همگرایی با زیرساخت، امنیت سیستم عامل اختصاصی DPU و جلوگیری از وابستگی به فروشنده متمرکز هستند. موفقیت در این معماریهای جدید نیازمند سرمایهگذاری در ابزارهای مدیریت یکپارچه، تخصص نرمافزاری سطح بالا و تعهد به مدیریت چرخه حیات پیچیده این شتابدهندهها است.

مقاله پیشنهادی:

افزایش امنیت و عملکرد دادهها در دیتاسنترها با رید کنترلر سرور اچ پی (HPE Smart Array